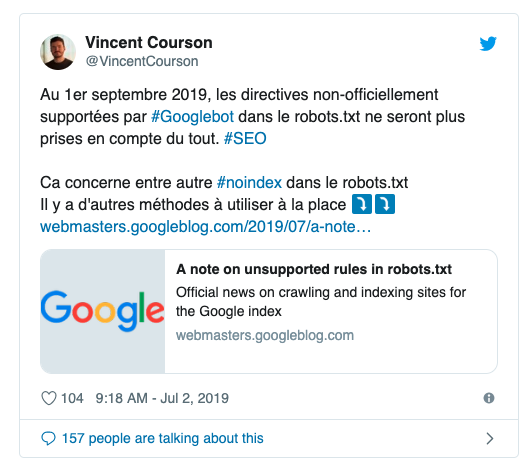

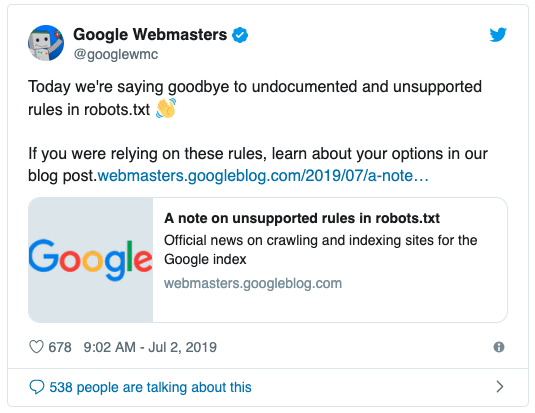

Ce mardi 2 juillet, Google a fait une déclaration importante sur les changements à venir vis-à-vis du support de certaines directives du fichier robots.txt. Une annonce qui s’inscrit le lendemain de la mise à disposition en open source du parser Google de ce même fichier robots.txt, si important en SEO.

Digimood vous propose de revenir sur cette annonce et de découvrir son impact potentiel sur le référencement des sites.

Petit rappel : qu’est-ce que le robots.txt ?

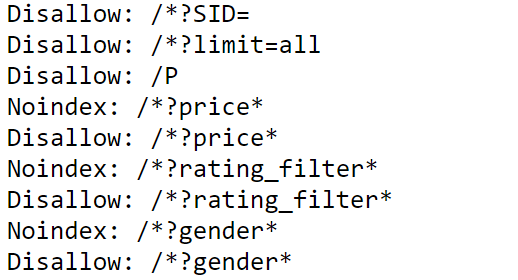

Le fichier robots.txt est un fichier très couramment utilisé dans le web. Il permet de donner aux différents robots d’exploration des instructions sur les zones et pages du site à explorer ou non. Officiellement, il doit être utilisé pour éviter de surcharger les serveurs des sites web avec des explorations « inutiles ». Mais dans la pratique, il est surtout important pour essayer d’éviter la présence de certaines pages dans les pages de résultats de recherche de Google et des autres moteurs.  1 : Exemple d’instructions dans un robots.txt

1 : Exemple d’instructions dans un robots.txt

Résumé de l’annonce de Google

Dans un premier temps, Google a annoncé le 1er juillet la mise à disposition en open source du parser C++ que le moteur utilise depuis plus de 25 ans déjà. Cette bibliothèque de ligne de code disponible sur Github permet ainsi aux développeurs et aux référenceurs de mieux comprendre comment le moteur interprète le robots.txt. Google a d’ailleurs également annoncé avoir soumis son algorithme à l’Internet Engineering Task Force pour que l’organisme reconnaisse ce dernier comme un standard international du web. En parallèle de cette nouvelle, la firme annonce avoir analysé l’usage du robots.txt dans le monde pour améliorer son utilisation par les référenceurs et webmasters. C’est ainsi que leurs équipes se sont notamment intéressées à des directives « plus rares » comme le nofollow, le craw-delay et le fameux noindex. Selon le communiqué officiel de Google, ces dernières sont aujourd’hui utilisées sur 0,001% des robots.txt du web et « entravent la présence des sites sur les résultats de recherche Google ». Et c’est ainsi qu’en se basant sur leur analyse, la firme a annoncé qu’à compter du 1er septembre 2019 ces directives ne seraient plus reconnues / plus traitées. Cette annonce n’est pas sans rappeler la suppression un peu brusque de la commande « info : » il y a quelques mois, qui n’avait pas manqué de faire réagir la communauté SEO. En effet, Google semble de plus en plus vouloir tronquer ou supprimer certaines fonctionnalités qu’il juge « obsolètes » et inutiles. Il s’agit pourtant de fonctionnalités qui sont encore très utiles aux référenceurs. Bien sûr, comme le précise Google il existe des alternatives à la directive noindex du robots.txt comme l’utilisation des balises meta, le renvoi d’un code 404 ou 410, le disallow, l’utilisation de la Search Console… Mais il faut reconnaître que le robots.txt est un support accessible, reconnu comme efficace. Il permet de centraliser facilement des actions très importantes pour le SEO. Par ailleurs, il ne demande pas de développements informatiques spécifiques, quelquefois coûteux et/ou délicats à entreprendre. Il est donc dommage de devoir s’en passer, surtout si subitement.

Besoin d’une expertise sur votre robots.txt ?

Si vous pensez que votre site peut être impacté par cette mesure, n’hésitez pas à contacter nos experts en référencement naturel. Nous proposons à nos clients un suivi détaillé et rigoureux pour leur permettre de gagner en visibilité malgré les aléas imposés par Google ?